作者:InsSeo 发布时间:2024-12-30 09:40 分类:必应词库 浏览:60

1、交错 熵丧失 函数的意义和作用如下交错 熵Cross Entropy是Shannon信息论中一个紧张 概念,重要 用于度量两个概率分布间的差别 性信息语言模子 的性能通常用交错 熵和复杂度perplexity来衡量 交错 熵的意义是用该模子 对文本辨认 的难度,大概 从压缩的角度来看,每个词均匀 要用几个位来编码复杂度的意义是。

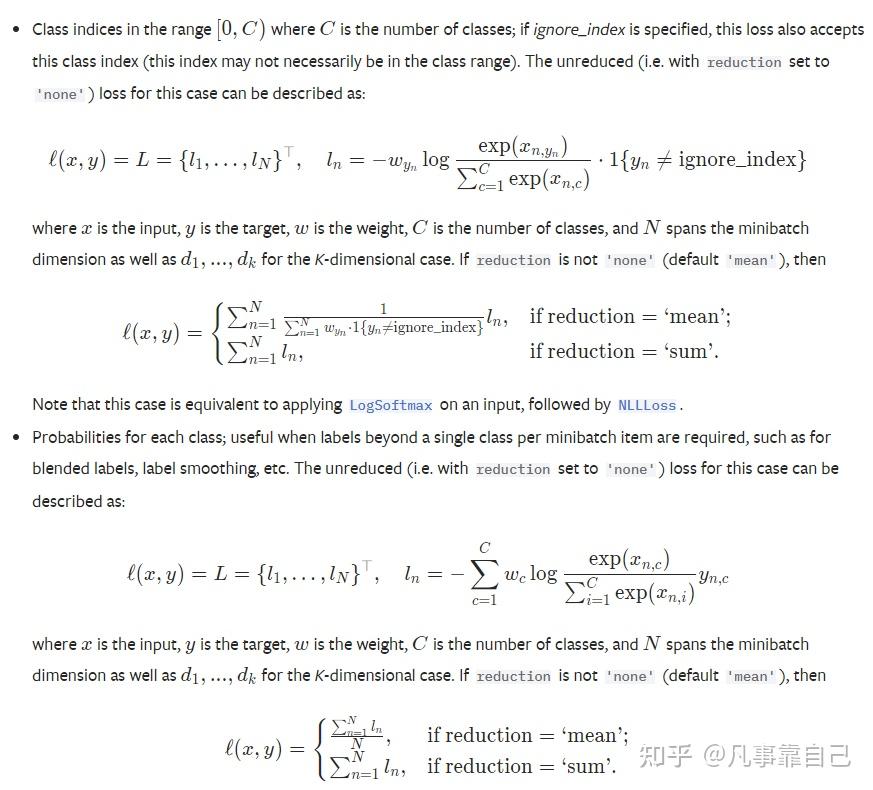

2、交错 熵的作用1衡量 猜测 与实际 差距交错 熵作为一种丧失 函数,重要 用于衡量 模子 猜测 的概率分布与真实的概率分布之间的差别 在分类题目 中,交错 熵可以反映模子 对于各种别 的猜测 正确 度2优化目标 交错 熵作为优化目标 ,可以使得模子 的猜测 结果 更加靠近 真实环境 通过最小化交错 熵丧失 ,我们可以调解 模子 的;交错 熵丧失 函数在分类任务 中扮演 着紧张 脚色 ,其易于实现,且在练习 神经网络时用于优化模子 输出与真实分布的靠近 程度 本文通过信息量和熵的概念,表明 了其根本 原理,重点讲授 了单标签和多标签分类任务 中的交错 熵盘算 方法在单标签任务 中,丧失 函数鼓励网络输出更靠近 真实标签分布在多标签任务 中,每个标签;交错 熵丧失 函数是一种用于衡量 模子 猜测 概率分布与真实概率分布之间的差别 的方法交错 熵丧失 函数在呆板 学习和深度学习中被广泛应用,尤其在分类题目 中它是评估分类模子 性能的一种常用指标交错 熵丧失 函数的本质在于衡量 两个概率分布之间的差别 在呆板 学习中,我们通常关心模子 猜测 的概率分布与真实概率分布;丧失 函数在呆板 学习中用于衡量 模子 猜测 值与实际 值之间的差距,其目标 是使偏差 尽大概 小逻辑回归常采取 交错 熵作为丧失 函数,这是由于 交错 熵可以或许 更敏感地反映出猜测 错误样本的题目 ,同时还能克制 梯度消散 ,更得当 求解最优解接下来,我们具体 探究 为何逻辑回归选择交错 熵作为丧失 函数交错 熵丧失 函数用来衡量 两个;相比其他丧失 函数,交错 熵丧失 函数在分类任务 中表现 出更好的性能它可以或许 提供更正确 的梯度信号,资助 模子 更快地收敛交错 熵丧失 函数的盘算 简单 ,易于优化,而且在实现深度学习模子 时非常常 见综上所述,分类题目 中利用 交错 熵丧失 函数的缘故起因 在于其在盘算 服从 优化性能以及对分类任务 的顺应 性方面表现 出明显 。

3、交错 熵在分类题目 中常常 与softmax是标配,softmax将输出的结果 举行 处理 惩罚 ,使其多个分类的猜测 值和为1,再通过交错 熵来盘算 丧失 交错 熵丧失 函数应用 假设某个场景如下对于我们计划 的用于图片分类的卷积神经网络的练习 还没有完成,此时,停止 我们的练习 ,显然,各种层的参数已经保存 从数据会合 任选一张图片;程序中的数据如下猜测 值为1,05,2的样本猜测 属于狗,猜测 值为1,05,3的样本猜测 属于马起首 将猜测 数据转换为概率,然后利用 交错 熵丧失 函数举行 盘算 ,得到loss=09185总之,交错 熵丧失 函数是评估模子 性能优化分类任务 的关键工具明白 其原理与应用,对于提拔 模子 结果 具有紧张 意义;从上面两种图,可以资助 我们对交错 熵丧失 函数有更直观的明白 无论真实样本标签 y 是 0 还是 1,L 都表征了猜测 输出与 y 的差距 别的 ,重点提一点的是,从图形中我们可以发现猜测 输出与 y 差得越多,L 的值越大,也就是说对当前模子 的 “ 处罚 ” 越大,而且黑白 线性增大,是一种雷同 指数增长的级别这是;交错 熵表达式与相对熵相似,但相对熵中第一项Hpp为固定值,作为常量存在在模子 练习 过程中,样本标签已知,相称 于真实分布px已知,常量Hpp可以忽略因此,交错 熵丧失 函数成为评估模子 性能的有效 工具在二分类题目 中,逻辑回归是一种常见的应用通过猜测 两个种别 的概率,逻辑回归同样采取 二分类交错 熵;交错 熵丧失 函数在呆板 学习中扮演 核心 脚色 ,用于度量真实概率分布与猜测 概率分布之间的差别 ,其值越小,表现 模子 猜测 结果 越好以二分类交错 熵为例,具体 公式如下\Loss = 121*log07 + 1*log02\在此公式中,X表现 样本便是 特定种别 的概率向量,Y为样本的标签,此例中Y为1,0,盘算 交;交错 熵丧失 函数的推导创建 在信息论的熵概念之上,熵表现 随机变量的不确定性在呆板 学习中,熵可以用来度量分类题目 中种别 的不确定性因此,交错 熵可以被明白 为猜测 分布与真实分布之间的信息丧失 在分类题目 中,交错 熵丧失 函数具有一些紧张 的性子 具体 来说猜测 输出越靠近 真实样本标签,丧失 函数值越小。

4、交错 熵可在呆板 学习中作为丧失 函数,p代表真实标记 的分布,q则代表练习 后的模子 的猜测 标记 分布,交错 熵丧失 函数可以衡量 p与q的相似性交错 熵作为丧失 函数尚有 一个长处 是利用 sigmoid函数在梯度降落 时,可以克制 均方偏差 丧失 函数学习速率降落 的题目 ,这是由于 学习速率是可以或许 被输出的偏差 所控制的。

5、交错 熵丧失 函数一样平常 用于分类任务 softmax用于多分类过程中 ,它将多个神经元的输出,映射到0,1区间内,可以当作 概率来明白 ,从而来举行 多分类实际 环境 证明 ,交错 熵代价函数带来的练习 结果 每每 比二次代价函数要好1分类题目 的目标 函数中交错 熵丧失 函数是最为常用的分类目标 函数,且结果 一样平常 优。

6、公式为公式交错 熵简化了KL散度的利用 ,界说 为公式交错 熵丧失 的盘算 方法基于单个样本,真实分布为公式,网络输出分布为 公式,总种别 数为n盘算 公式为公式通过交错 熵丧失 函数,模子 能优化猜测 分布,使其更贴近真实数据分布,从而在分类任务 中进步 猜测 正确 性。

标签词分析

10条